Robot bestuurd door mind-control?

Volgens een artikel op Extreme Tech (Extreme Tech, 6 juli 2012) is het nu voor het eerst gelukt om een robot te laten besturen door de gedachtenstroom van een mens op 2000 kilometer afstand. ![]() Het artikel vertelt dat Tirosh Shapira een robot liet bewegen in Frankrijk, terwijl hij in een mri-scanner in Israël lag. De mri-scanner registreerde hoe de verdeling van zijn hersenactiviteit veranderde over de tijd met een fMRI scan. Tirosh stelde zich in Israel voor dat hij zijn eigen lichaam bewoog in zijn gedachten, de computer vertaalde de corresponderende hersenactiviteit en stuurde deze in de vorm van commands naar Frankrijk, waardoor de robot dezelfde bewegingen liet zien.

Het artikel vertelt dat Tirosh Shapira een robot liet bewegen in Frankrijk, terwijl hij in een mri-scanner in Israël lag. De mri-scanner registreerde hoe de verdeling van zijn hersenactiviteit veranderde over de tijd met een fMRI scan. Tirosh stelde zich in Israel voor dat hij zijn eigen lichaam bewoog in zijn gedachten, de computer vertaalde de corresponderende hersenactiviteit en stuurde deze in de vorm van commands naar Frankrijk, waardoor de robot dezelfde bewegingen liet zien.

Een MRI-scanner meet met een fmri scan eigenlijk helemaal geen hersenactiviteit, maar hij meet hoe de verdeling van bloed toevoer over de hersenen verandert over de tijd. Men neemt aan dat er bloed stroomt naar alle neuronen die net actief zijn geweest. Omdat dit natuurlijk sterk met elkaar samenhangt, wordt er vaak gezegd dat er met fmri hersenactiviteit wordt gemeten.

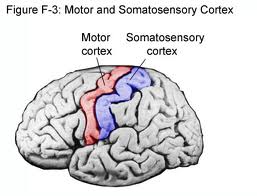

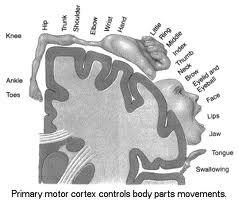

Bewegen of denken aan bewegen zorgt voor hersenactiviteit in de motorcortex. De motorcortex is een strook hersenen die loopt ongeveer van je linkeroor over je hoofd naar je rechteroor (rood in het plaatje hier beneden). Ieder stukje van de motorcortex correspondeert met de beweging van een specifiek deel van je lichaam. Hierbeneden zie je de helft van een dwarsdoorsnede door de motorcortex. Zo zie je bijvoorbeeld een groot deel dat correspondeert met je tong en een kleiner deel dat correspondeert met je schouder. Omdat ieder lichaamsdeel correspondeert met een specifiek stukje hersenen, is het mogelijk om met een fMRI scan te zien welk lichaamsdeel iemand in zijn gedachten beweegt.

Ieder stukje van de motorcortex correspondeert met de beweging van een specifiek deel van je lichaam. Hierbeneden zie je de helft van een dwarsdoorsnede door de motorcortex. Zo zie je bijvoorbeeld een groot deel dat correspondeert met je tong en een kleiner deel dat correspondeert met je schouder. Omdat ieder lichaamsdeel correspondeert met een specifiek stukje hersenen, is het mogelijk om met een fMRI scan te zien welk lichaamsdeel iemand in zijn gedachten beweegt.  Deze precieze verdeling van de lichaamsdelen over de hersenen verschilt (op de vierkante millimeter) per persoon. Het is daarom nodig dat een computer leert welk patroon van hersenactiviteit bij welk lichaamsdeel hoort bij deze specifieke persoon. Tijdens deze training kan een computer ook de meer ingewikkelde patronen in hersenactiviteit leren herkennen die laten zien hoe de proefpersoon wil dat het lichaamsdeel beweegt. De computer vertaald de herkende hersenactiviteit-patronen vervolgens naar commands voor de robot in Frankrijk die deze bewegingen vervolgens uitvoert. De beelden die real-time door een camera op de robot gefilmd worden worden zo geprojecteerd dat de proefpersoon in de scanner ze voor zich ziet verschijnen. Zo ontstaat de echte Avatar-beleving!

Deze precieze verdeling van de lichaamsdelen over de hersenen verschilt (op de vierkante millimeter) per persoon. Het is daarom nodig dat een computer leert welk patroon van hersenactiviteit bij welk lichaamsdeel hoort bij deze specifieke persoon. Tijdens deze training kan een computer ook de meer ingewikkelde patronen in hersenactiviteit leren herkennen die laten zien hoe de proefpersoon wil dat het lichaamsdeel beweegt. De computer vertaald de herkende hersenactiviteit-patronen vervolgens naar commands voor de robot in Frankrijk die deze bewegingen vervolgens uitvoert. De beelden die real-time door een camera op de robot gefilmd worden worden zo geprojecteerd dat de proefpersoon in de scanner ze voor zich ziet verschijnen. Zo ontstaat de echte Avatar-beleving!